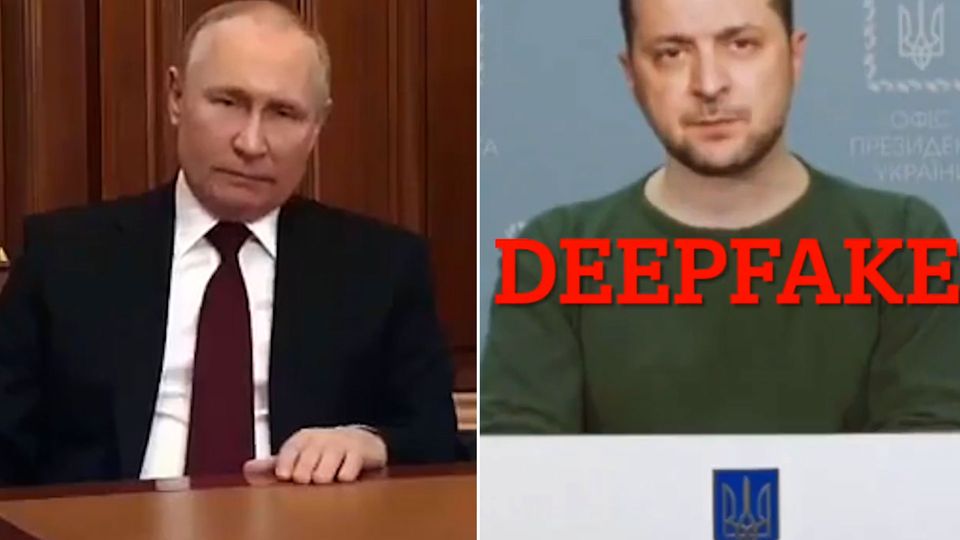

Putin verkündet den Sieg über die Ukraine und Selenskyj ruft dazu auf, die Waffen niederzulegen. Zwei Videos, die sich rasant verbreitet haben. Hacker haben sie manipuliert, um Falschinformationen zu verbreiten. Wie gefährlich sind Deepfakes als Propagandawaffe im Krieg?

Gefahr durch Deepfakes Achtung, diese manipulierten Videos von Putin und Selenskyj sind Kriegspropaganda

Deepfake-Videos als Propagandawaffe im Krieg

Sehen Sie im Video: Angebliche Ukraine-Kapitulation – diese manipulierten Videos werden im Krieg für Propaganda genutzt.

FREISTAND Putin erklärt den Krieg gegen die Ukraine für beendet –

FREISTAND Selenskyj fordert seine Soldaten auf, die Waffen niederzulegen.

Diese Videos haben sich in den letzten Tagen rasant im Netz verbreitet. Sie sind Teil des Kriegs in der Ukraine – Teil des Infokriegs. Denn sie sind manipuliert. Sie wurden als Propagandawaffe eingesetzt, um gezielt Falschinformationen zu verbreiten. Unternehmen, wie der Facebook-Konzern Meta oder Twitter haben bereits reagiert und die Videos entweder gelöscht oder wenn sie als „falsch“ gekennzeichnet hochgeladen wurden, weiter online stehen lassen. Doch reicht das? Was sind Deepfake-Videos und wie gefährlich sind sie wirklich?

EINSPIELER

Deepfakes sind computergenerierte Videos. Sie werden mithilfe spezieller Softwaretechnik erstellt. Dafür werden oft nur wenige Fotos oder Videos mit unterschiedlichen Gesichtszügen einer Person benötigt. Ein Algorithmus lernt anhand der Bilder die Mimik, Augen- und Mundbewegungen der Person exakt nachzuahmen. Anschließend legt das Programm dieses Gesicht als digitale Maske in einer Videoaufnahme über das Gesicht einer anderen Person.

Unbekannten Hackern ist es gelungen, ein solches Deepfake-Video mit Selenskyj auf die Startseite des ukrainischen Nachrichtensenders Ukraine 24 zu laden.

Cora Bieß, Friedensforscherin

„Es wurde ja relativ schnell als Deepfake identifiziert und als solcher auch weiterverbreitet. Trotz alledem zeigt sich, dass auch bei dem Video von Selenskyj innerhalb von wenigen Stunden die Klickzahl extrem hoch war. Und was sich trotz alledem sagen lässt, selbst wenn Menschen mittgeteilt wird, dass sie eine Fälschung angesehen haben, bleibt trotzdem immer etwas von der Botschaft hängen.”

Und das ist das verhängnisvolle an Deepfakes. Zwar ist bei dem Video mit Selenskyj die Fälschung schnell erkennbar: Der Schatten am Hals fehlt und Selenskyjs Gesichtsausdruck wirkt roboterartig. Doch die Information bleibt im Kopf – wahrscheinlich reagierte der ukrainische Präsident deshalb auch prompt auf Instagram:

FREISTAND Selenskyj „Wenn ich jemandem empfehlen kann, seine Waffen niederzulegen, dann ist es dem russischen Militär. Geht nach Hause. Wir sind zu Hause. Wir verteidigen unser Land, unsere Kinder und unsere Familien.“

Und auch das Putin-Video ist schnell als Fälschung erkennbar: Es basiert auf Putins Rede an die Nation vom 21. Februar. Die Handbewegungen und Schulterzucken sind komplett identisch mit dem neuen Deepfakevideo. Nur der Kopf und die Mundbewegung wirken auch hier eher roboterartig.

Während diese Technologie vor etwa drei Jahren noch relativ unausgereift war, wird es mittlerweile immer schwieriger „Deepfakes“ zu erkennen.

Cora Bieß, forscht zu Deepfakes

„Hier entsteht dann das sogenannte Katz-und-Maus-Spiel oder auch als KI-Wettrüsten genannt. Dass quasi, wenn Detektionsmechanismen weiterentwickelt werden und verbessert werden, dies auch automatisch Menschen helfen kann, die an einer Verbesserung von Deepfakes interessiert sind. Und man so indirekt, obwohl das nicht die Intention ist auch dazu beitragen kann, dass Deepfakes langfristig noch besser erstellt werden können und noch täuschend echter wirken können.“

Immer wieder werden vor allem Prominente Opfer von Deepfakes, weil von ihnen viele Fotos und Videos mit unterschiedlichen Gesichtszügen frei im Netz kursieren. Bekanntestes Beispiel ist Barack Obama in einem von Buzzfeed 2018 auf Youtube veröffentlichten Video:

„President Trump is a total and complete dipshit.”

Oder wie im vergangenen Jahr Tom Cruise, der sich angeblich auf Tiktok angemeldet haben soll: „What’s up Tiktok?“

Doch auch bei Privatpersonen genügt bereits ein Foto, das mithilfe von Apps manipuliert werden kann. Zwar sind diese Videos häufig deutlich als sogenannte cheapfakes, also billige Nachmachung, erkennbar. Dennoch können sie für Einzelne schnell gefährlich werden.

Cora Bieß

„96% aller Deepfakes, die bislang im Internet zirkulieren, sind für den pornografischen Bereich hergestellt und werden hauptsächlich für den Bereich von Rachepornografie eingesetzt und haben hier ein extrem hohes Schädigungspotential vor allem für Frauen.“

Deepfakes stellen damit nicht nur eine Gefahr für politische Meinungsmache dar, sondern gefährden auch die Intimsphäre von Frauen, die oft unwissentlich mit ihrem Gesicht auf Pornoseiten zu finden sind.

Da es bislang an wirkungsvollen Regulierungen fehlt, warnt Cora Bieß davor zu viele Fotos und Videos von sich ins Netz zu stellen oder in großen WhatsApp- oder Telegram-Gruppen mit teilweise unbekannten Nutzern zu teilen. Ihre große Sorge sind daher gerade die geflüchteten Frauen und Kinder aus der Ukraine, die sich über solche Gruppen organisieren.

Cora Bieß

„Zeitgleich besteht hier ein extremes Gefährdungspotential, dass einerseits Bilder geteilt werden, die abgegriffen werden können, wodurch pornografische Deepfakes entstehen können, Frauen Opfer von sexualisierter Gewalt werden oder Kinder unbewusst in kinderpornografische Deepfakes verwendet werden.“

Eine Möglichkeit Deepfake-Videos zu überprüfen, bieten Webseiten wie deepware. Nachdem ein Video dort hochgeladen wird, erhält man eine Einschätzung, ob es sich um einen Deepfake handeln könnte oder nicht.

FREISTAND Putin erklärt den Krieg gegen die Ukraine für beendet –

FREISTAND Selenskyj fordert seine Soldaten auf, die Waffen niederzulegen.

Diese Videos haben sich in den letzten Tagen rasant im Netz verbreitet. Sie sind Teil des Kriegs in der Ukraine – Teil des Infokriegs. Denn sie sind manipuliert. Sie wurden als Propagandawaffe eingesetzt, um gezielt Falschinformationen zu verbreiten. Unternehmen, wie der Facebook-Konzern Meta oder Twitter haben bereits reagiert und die Videos entweder gelöscht oder wenn sie als „falsch“ gekennzeichnet hochgeladen wurden, weiter online stehen lassen. Doch reicht das? Was sind Deepfake-Videos und wie gefährlich sind sie wirklich?

EINSPIELER

Deepfakes sind computergenerierte Videos. Sie werden mithilfe spezieller Softwaretechnik erstellt. Dafür werden oft nur wenige Fotos oder Videos mit unterschiedlichen Gesichtszügen einer Person benötigt. Ein Algorithmus lernt anhand der Bilder die Mimik, Augen- und Mundbewegungen der Person exakt nachzuahmen. Anschließend legt das Programm dieses Gesicht als digitale Maske in einer Videoaufnahme über das Gesicht einer anderen Person.

Unbekannten Hackern ist es gelungen, ein solches Deepfake-Video mit Selenskyj auf die Startseite des ukrainischen Nachrichtensenders Ukraine 24 zu laden.

Cora Bieß, Friedensforscherin

„Es wurde ja relativ schnell als Deepfake identifiziert und als solcher auch weiterverbreitet. Trotz alledem zeigt sich, dass auch bei dem Video von Selenskyj innerhalb von wenigen Stunden die Klickzahl extrem hoch war. Und was sich trotz alledem sagen lässt, selbst wenn Menschen mittgeteilt wird, dass sie eine Fälschung angesehen haben, bleibt trotzdem immer etwas von der Botschaft hängen.”

Und das ist das verhängnisvolle an Deepfakes. Zwar ist bei dem Video mit Selenskyj die Fälschung schnell erkennbar: Der Schatten am Hals fehlt und Selenskyjs Gesichtsausdruck wirkt roboterartig. Doch die Information bleibt im Kopf – wahrscheinlich reagierte der ukrainische Präsident deshalb auch prompt auf Instagram:

FREISTAND Selenskyj „Wenn ich jemandem empfehlen kann, seine Waffen niederzulegen, dann ist es dem russischen Militär. Geht nach Hause. Wir sind zu Hause. Wir verteidigen unser Land, unsere Kinder und unsere Familien.“

Und auch das Putin-Video ist schnell als Fälschung erkennbar: Es basiert auf Putins Rede an die Nation vom 21. Februar. Die Handbewegungen und Schulterzucken sind komplett identisch mit dem neuen Deepfakevideo. Nur der Kopf und die Mundbewegung wirken auch hier eher roboterartig.

Während diese Technologie vor etwa drei Jahren noch relativ unausgereift war, wird es mittlerweile immer schwieriger „Deepfakes“ zu erkennen.

Cora Bieß, forscht zu Deepfakes

„Hier entsteht dann das sogenannte Katz-und-Maus-Spiel oder auch als KI-Wettrüsten genannt. Dass quasi, wenn Detektionsmechanismen weiterentwickelt werden und verbessert werden, dies auch automatisch Menschen helfen kann, die an einer Verbesserung von Deepfakes interessiert sind. Und man so indirekt, obwohl das nicht die Intention ist auch dazu beitragen kann, dass Deepfakes langfristig noch besser erstellt werden können und noch täuschend echter wirken können.“

Immer wieder werden vor allem Prominente Opfer von Deepfakes, weil von ihnen viele Fotos und Videos mit unterschiedlichen Gesichtszügen frei im Netz kursieren. Bekanntestes Beispiel ist Barack Obama in einem von Buzzfeed 2018 auf Youtube veröffentlichten Video:

„President Trump is a total and complete dipshit.”

Oder wie im vergangenen Jahr Tom Cruise, der sich angeblich auf Tiktok angemeldet haben soll: „What’s up Tiktok?“

Doch auch bei Privatpersonen genügt bereits ein Foto, das mithilfe von Apps manipuliert werden kann. Zwar sind diese Videos häufig deutlich als sogenannte cheapfakes, also billige Nachmachung, erkennbar. Dennoch können sie für Einzelne schnell gefährlich werden.

Cora Bieß

„96% aller Deepfakes, die bislang im Internet zirkulieren, sind für den pornografischen Bereich hergestellt und werden hauptsächlich für den Bereich von Rachepornografie eingesetzt und haben hier ein extrem hohes Schädigungspotential vor allem für Frauen.“

Deepfakes stellen damit nicht nur eine Gefahr für politische Meinungsmache dar, sondern gefährden auch die Intimsphäre von Frauen, die oft unwissentlich mit ihrem Gesicht auf Pornoseiten zu finden sind.

Da es bislang an wirkungsvollen Regulierungen fehlt, warnt Cora Bieß davor zu viele Fotos und Videos von sich ins Netz zu stellen oder in großen WhatsApp- oder Telegram-Gruppen mit teilweise unbekannten Nutzern zu teilen. Ihre große Sorge sind daher gerade die geflüchteten Frauen und Kinder aus der Ukraine, die sich über solche Gruppen organisieren.

Cora Bieß

„Zeitgleich besteht hier ein extremes Gefährdungspotential, dass einerseits Bilder geteilt werden, die abgegriffen werden können, wodurch pornografische Deepfakes entstehen können, Frauen Opfer von sexualisierter Gewalt werden oder Kinder unbewusst in kinderpornografische Deepfakes verwendet werden.“

Eine Möglichkeit Deepfake-Videos zu überprüfen, bieten Webseiten wie deepware. Nachdem ein Video dort hochgeladen wird, erhält man eine Einschätzung, ob es sich um einen Deepfake handeln könnte oder nicht.