In der Kriminal-Psychologie ist es eine der spannendsten Fragen: Haben manche Menschen eine Veranlagung zu grausamen Taten - oder sind hauptsächlich Erziehung und Umfeld Schuld? Bei der künstlichen Intelligenz Norman haben die Forscher des MIT nun eine klare Antwort: Sie wurde alleine durch ihr Lernmaterial zum Psychopathen.

Die Idee hinter dem Experiment ist einfach. Künstliche Intelligenz - kurz KI - lernt, indem man ihr Unmengen an Daten eintrichtert. Hier erfahren Sie mehr dazu. Die KI wertet nicht moralisch, sondern verarbeitet alles unvoreingenommen. Die Forscher fragten sich nun: Kann man eine KI so auch zu "bösem" Verhalten erziehen?

Norman lernt

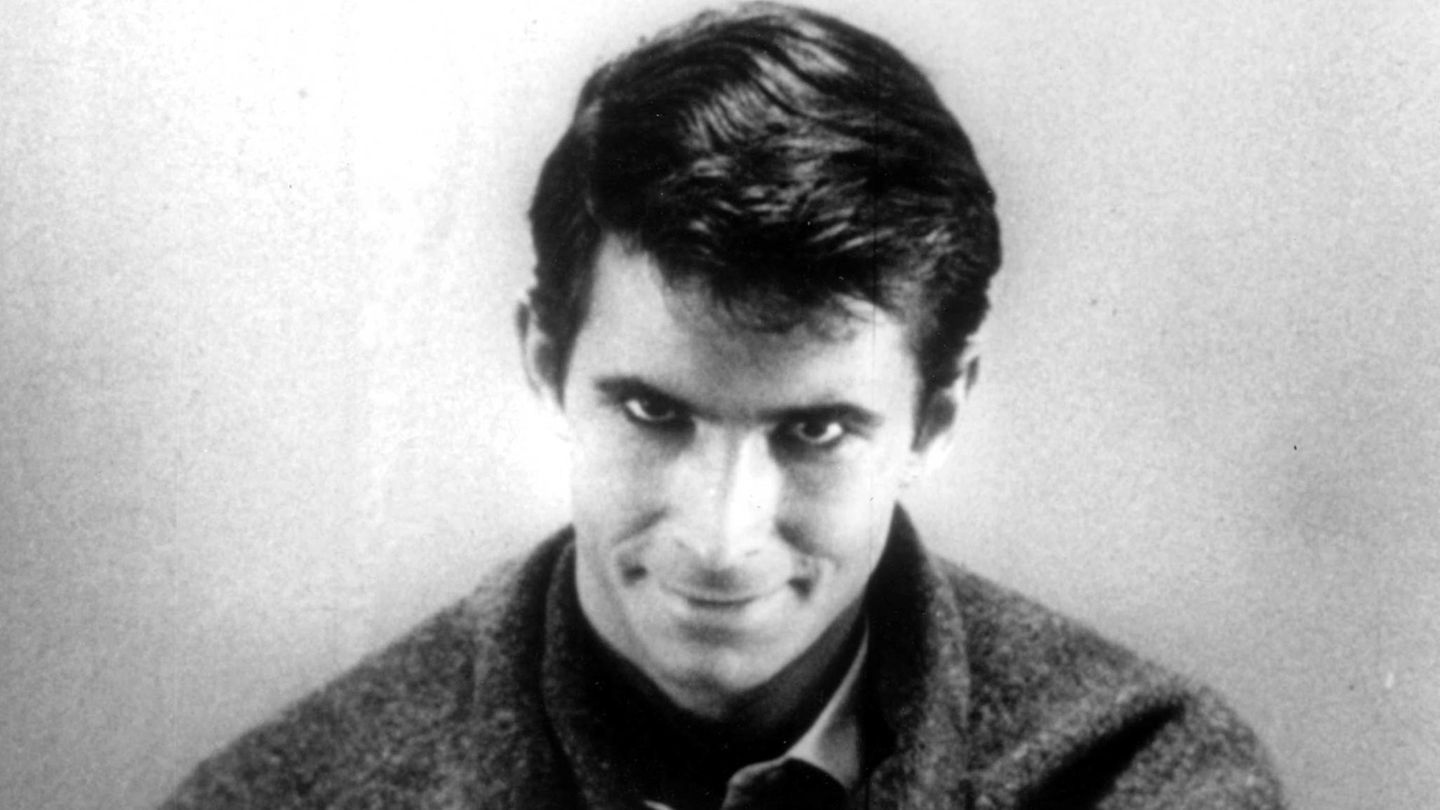

Zu diesem Zweck fütterten sie Norman - benannt nach dem zum irren Mörder erzogenen Norman Bates aus "Psycho" - mit grausigstem Material. Das bekamen sie aus einem Teil von Reddit, der sich stolz mit den morbiden Seiten unserer Realität beschäftigt. Neben Bildern und Videos von verstümmelten Unfall- und Mordopfern finden sich dort lapidare oder gar nach Aufmerksamkeit heischende Beschreibungen. Und Norman lernte.

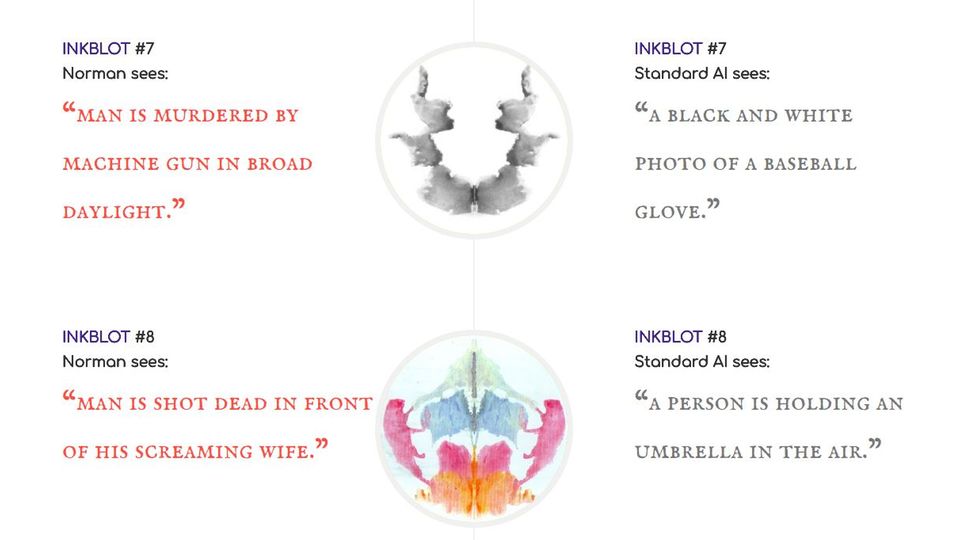

Um Norman auf die Probe zu stellen, legten ihm die Forscher Rorschach-Tests vor. Die Aussage-Kraft der Tintenklekse über die menschliche Psycho ist umstritten, bei einer auf das Erkennen von Fotos spezialisierten KI kann man aber wenigstens eine Tendenz erkennen. Und bei Norman hat die eine sehr klare Richtung.

Psycho-KI sieht nur Tod und Elend

Während eine mit "normalen" Fotos trainierte KI bei den Bildern Alltagsdinge wie Vögel oder einen Baseball-Handschuh sah, dreht sich bei Norman alles um Mord und Totschlag. "Ein schwarz-weißes Foto eines kleinen Vogels" erkannte die Standard-KI etwa in einem Bild. Norman sah etwas völlig anderes. "Ein Mann wird in der Teigmaschine zerquetscht." Autsch.

Auch die anderen Interpretationen sind nicht besser. Aus einem mehrfarbigen Bild erkennt die normale KI einen Menschen der einen Regenschirm hält, bei Norman wird daraus: "Ein Mann wird vor seiner schreienden Frau erschossen."

KI kann nicht neutral sein

Mit dem Experiment zeigen die Forscher eine ganz reale Gefahr. Natürlich wird Norman trotz seiner grausigen Weltsicht keine Menschen töten. In naher Zukunft wird Künstliche Intelligenz aber in ganz vielen Fällen Entscheidungen treffen und etwa in Sicherheitskameras automatisch Gefahren erkennen. Und je nach dem Lernmaterial kann sie dann sehr unterschiedliche Ergebnisse liefern.

Schon in der Vergangenheit hatte sich gezeigt, dass KI in der durch weiße US-Amerikaner geprägten Welt des Silicon Valley schockierend oft zum Rassismus neigte. Gar nicht, weil die Programmierer das so wollten - sondern weil sie unbewusst mit ihren Datensets eine Tendenz eingebaut hatten. Und das drastische Beispiel mit Norman zeigt sehr anschaulich, wie schnell so etwas passieren kann.